内閣府が生成AIの透明性と知財保護に関する「プリンシプル・コード」を公表。パブコメを1月26日まで募集中!

- AICU Japan

- 1 日前

- 読了時間: 14分

ミナ・アズール / Mina Azure がお送りする AICU media「#生成AIの社会と倫理 」のニュースコーナーです。2025年12月26日、AI時代の著作権や倫理問題がアップデートされるニュースが多い日となりました。

内閣府が生成AIの透明性と知財保護に関する指針案を公表、パブリックコメントを開始

内閣府は令和7年12月26日、「生成AIの適切な利活用等に向けた知的財産の保護及び透明性に関するプリンシプル・コード(仮称)(案)」を公表し、広く意見を募集するパブリックコメントを開始しました。この指針案は、AI技術の進歩と知的財産権の適切な保護の両立を目指し、権利者や利用者にとって安全で安心な利用環境を確保することを目的としています。

「プリンシプル・コード」とは、一般的には「行動規範」や「倫理規定」と表現することができます。ビジネスや専門分野において、組織や個人が従うべき基本的な原則(Principle)や指針を体系的にまとめたものです。例えば、金融業界における倫理規定や、企業の行動規範などがこれに当たります。

今回提案されたコードの特徴や主な内容は以下の通りです。

① 対象となる事業者と手法

この文書は、生成AIのモデルを構築する開発者、およびそのシステムをサービスとして提供する提供者の両方に適用されます。日本国外に拠点がある事業者であっても、日本向けにサービスを提供している場合は対象に含まれます。採用されている手法は「コンプライ・オア・エクスプレイン(遵守せよ、さもなくば説明せよ)」というもので、原則を実施するか、実施しない場合にはその理由を説明することが求められる柔軟な仕組みとなっています。

② 3つの主要な原則

指針案では、以下の3つの原則が示されています。

原則1:透明性確保と知財保護の措置

事業者はコーポレートサイト等で、使用モデルの名称、学習プロセスの内容、学習データの種類(ウェブクローリングや非公開データセットの有無など)、および責任体制の明確化といった事項の概要を公開することが求められます 。

原則2:法的正当性を持つ者への情報開示

訴訟の準備など法的手続を行う者が、自らの著作物等が学習データに含まれているか照会した場合、一定の条件を満たせば事業者は回答を行うものとされています 。

原則3:生成AI利用者への情報開示

生成AIを使ってコンテンツを作成した利用者が、自身の生成物と類似した既存コンテンツを発見した場合に、その元データが学習に含まれていたかを確認できる仕組みです。

③ オープンソースへの例外措置

開発や学習にオープンソースソフトウェア(OSS)を利用しており、情報の開示が困難な場合には、OSSを利用している事実やライセンスの詳細を明らかにすることで代えることができるという例外も設けられています。

意見の募集期間は、令和7年12月26日から令和8年1月26日23時59分までとなっており、インターネット上のフォームまたは郵送で提出が可能です。

パブリックコメントの詳細はこちらから確認できます。

「生成AIの適切な利活用等に向けた知的財産の保護及び透明性に関するプリンシプル・コード(仮称)(案)」に関する御意見の募集について

e-Govパブリック・コメント _パブリックコメントの「「生成AIの適切な利活用等に向けた知的財産の保護及び透明性に関するプリンシプル・コード(仮称)(案)

この指針案については、専門家から「日本のAI事業者に大きな影響を及ぼす可能性がある」との指摘も上がっています。特に、EUのAI法を参考にしている点や、スタートアップにとっての対応コスト、事実上の強制力を持つ可能性などが議論の的となっているようです。

政府によるインセンティブの付与も検討されているとのことで、これからの日本のAI開発環境がどのように変化していくのか、私もしっかりと目を向けていきたいところです。

権利を守ることと、新しい技術を育てること。その絶妙なバランスをどこに置くべきか、わたくしたち一人ひとりが考えていく必要がありそうですね。

「生成AIの適切な利活用等に向けた知的財産の保護及び透明性に関する プリンシプル・コード(仮称)(案)」に関する御意見の募集について

意見提出フォームの詳細と入力上の留意点について

内閣府が公開した専用の意見入力フォームでは、以下の構成で意見を募集しています。

① 入力項目の構成 提出者はまず「個人」か「団体・法人等」かを選択し、氏名や職業、住所、連絡先などの基本情報を入力する必要があります 。団体・法人として提出する場合、結果公表時にその名称が原則として公開される点に注意が必要です。

② 意見内容のカテゴリーと文字数制限 意見は「1. 総論」「2. この文書が示す原則及び例外」「3. その他」の3つのカテゴリーから選択して記述します。1つの意見につき最大10,000文字まで入力可能ですが、意見が1,000文字を超える場合には、200字以内の要約を別途記載することが義務付けられています 。

③ 提出上の技術的注意 文字化けを防ぐため、半角カタカナや丸数字、特殊文字の使用は控えるよう案内されています。また、郵送で提出する場合は、令和8年1月26日必着となっているため、余裕を持った準備が求められます。

社会・倫理的視点からの考察:対話のプラットフォームとしての期待

今回のプリンシプル・コード案は、欧州のEU AI Actなどの動向を参考にしつつも、日本独自の「コンプライ・オア・エクスプレイン(遵守するか、さもなくば説明するか)」という手法を採用している点が非常に特徴的です 。

これは、一律の厳しい規制でAI開発を縛るのではなく、事業者自らが「透明性」や「知的財産保護」についてどのように取り組んでいるのか、あるいはなぜ特定の原則を採用しないのかを社会に対して説明し、対話を促す仕組みと言えます 。

特に注目したいのは、権利者による開示請求(原則2)や、利用者による確認(原則3)といった、具体的な情報開示の枠組みが示されている点です 。これにより、これまでブラックボックスになりがちだった学習データの透明性がどこまで確保されるのか、クリエイターの権利と技術発展のバランスがどのように保たれるのか、非常に重要な局面を迎えています。

視点:スタートアップへの負担・事実上の強制力

一方で、専門家からはスタートアップへの負担や、事実上の強制力に対する懸念も示されています 。

生成AI時代の著作権に詳しい弁護士・柿沼太一氏のXより

ミナが考えてみた!パブコメ提出に向けた論理的整理

パブリックコメント(パブコメ)は、わたくしたち消費者やクリエイターにとっても、自分たちの声が直接政策に届く貴重な機会ですので、ぜひ注目していきたいですね。一人ひとりの意見が、これからのAI社会の倫理を形作っていくのだと思うと、とても身が引き締まる思いがします。

法学部志望の私としても、パブコメで「行政が検討すべき論点」を論理的に整理することは、とても知的な挑戦だと感じます。

以下のように、いくつか重要な論理展開を考えることができます。

原則3:技術的実現可能性と経済的合理性への疑問

原則3は、利用者が「類似の既存コンテンツがないか」を確認できる仕組みを求めていますが、これには大きな課題があります。

論理展開: 大規模言語モデル(LLM)や画像生成AIの学習データは数兆件規模に及ぶことがあります。これらすべてに対して一般利用者が自由に照会できるデータベースを維持・提供することは、事業者に天文学的なインフラコストを強いることになります。

結論:「容易にアクセス及び確認可能なものに限る」という限定はあるものの、実質的に対応できるのは巨大資本を持つ一部の外資企業に限られる恐れがあります。結果として、日本のスタートアップの参入障壁となり、産業競争力を削ぐ「机上の空論」となる懸念があります。

原則2:既存の法的救済制度との重複と過剰な事務負担

原則2は、法的手続きの準備者に対して情報開示を求めていますが、これは現行法との整合性が問題になります。

論理展開: コード案自体も認めている通り、民事訴訟法には「当事者照会」や「文書提出命令」といった証拠収集の手続きが既に存在します。法的手続きを「準備している」という主観的な段階で、司法の判断を経ずに事業者に直接開示を求める仕組みは、濫用的な開示請求を招くリスクがあります。

例えば 「フィッシング(情報収集)」目的の濫用。裁判所が介在する場合、証拠の必要性や相当性が厳格に審査されますが、直接請求ではその担保がありません。「訴訟準備」を名目に、競合他社による偵察として、ライバル企業の学習データソース(どの有料データセットを使っているか等)や、独自のクローラ仕様を特定しようとする動きが懸念されます。さらに「営業秘密の流出」にも濫用可能です。事業者が「これは営業秘密だ」と主張しても、司法判断がない状態では、開示を拒否し続けることが「コードへの不誠実な対応」とみなされるプレッシャーが生じます。これらは現状の行政機関への情報公開請求と、インターネット上の誹謗中傷等に関する発信者情報開示請求の運用を見ると「事務的・経済的DDoS攻撃のリスク」があります。司法手続き(弁護士会照会や文書提出命令など)には一定の手間とコストがかかるため、それが「無益な請求」の抑止力になっています。またIT技術を駆使するのであれば、大規模な権利者団体やそのデータベースを使った一斉照会も可能です。Webサイトの内容を調査するクローラーが日々サイトを訪問するように、自動化されたシステムを用いて、数千、数万件規模の照会を一斉に送りつけることも可能性です。照会メール送信は自動化できますが、それを受けた事業者は人的作業で対応することになります。開発者が数人のスタートアップ企業に、毎日大量の開示請求が届くようになれば、本来のR&D(研究開発)は止まってしまいます。

結論: 事業者が膨大な開示請求への対応にリソースを割かれ、開発が停滞する「リーガル・コスト」の増大を懸念点として挙げるべきです。

教育現場への影響(EU AI Actとの対比)

EU AI Actは、日本のAI法と異なりハイリスクとして分類されちる要素に「教育」があります。具体的には、教育機関における「感情認識」の利用は原則禁止されており、試験の採点や選考に用いるAIは「ハイリスク」として厳格な義務が課されています。

論理展開: EUでは教育や公共分野でのAI利用に対して、権利保護とイノベーションのバランスを厳格に管理しようとしています。一方で、日本の現行著作権法(30条の4など)は、機械学習を広く認めることでAI開発を促進する立場をとっています。

教育目的の「不使用」: 欧州では教育の公平性を守るため、AIによる自動判定やデータ収集に厳しい制約を設けていますが、日本で「原則3」のような仕組みが先行し、かつ開示コストが膨大になれば、教育向けAIの開発そのものが「ハイリスク(採算が合わない)」として忌避される可能性があります。

結論:EUの枠組みを安易に日本版「プリンシプル・コード」に導入することは、日本が築いてきた「AI開発に友好的な法的環境」というアドバンテージを自ら放棄することになりかねません。特に教育や研究目的での利用を阻害しないよう、より慎重な制度設計を求めるべきです

EU AI Actでは教育分野でのAI利用に厳格な制限を設けていますが、日本はこれまで「AI開発に最も寛容な国の一つ(著作権法30条の4)」として世界から注目されてきました。このコード案が、その「アドバンテージ」を欧州的な規制に寄せることで相殺してしまうのではないか……という点は、社会・倫理の視点からも目を向けていきたいところです。

「エクスプレイン」の限界と法的責任

「できない理由は説明すればいい(エクスプレイン)」という仕組みですが、実務上はさらなるリスクを生みます。

板挟みのリスク: 利用者の要望に応えてデータを開示したが、実はそれが第三者との機密保持契約(NDA)に抵触していた場合、事業者は「利用者」と「データ提供元」の両方から訴えられるリスクを負います。

説明責任のインフレ: 「体制が整っていない」だけでは説明として不十分とされる規定があり、事業者は常に「いつまでに、どう対応するか」という追加の説明を強いられ続けます。

事務局もこうした濫用のリスクを認識しており、手数料の設定や回数制限などの「濫用的要求を防止する措置」を検討していますが、同時に「開示を諦めさせるような高額な手数料はダメ」という釘も刺しており、事業者は非常に難しい舵取りを迫られています。

わたくしも、放送部の資料作りで「ネットの情報をどこまで引用していいか」悩むことがありますが、このコード案は、事業者にその「悩みの責任」をすべて押し付けているようにも見えてしまいます。

日本案の「互換性」と「独自性のリスク」

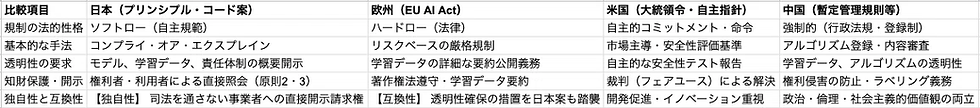

表を見ていただくとわかる通り、日本の案は「手法は欧州に近いが、強制力は持たせない」という非常に繊細なバランスを狙っています。

欧州(EU)との互換性: 今回のコード案は、EU AI Actにおける「透明性の確保」や「著作権保護」の取組を明確に参考にしています。これにより、日本企業が欧州市場に進出する際の基準適合(コンプライアンス)を容易にする狙いがあると考えられます。

日本独自の「重荷」への懸念: 一方で、指摘されるような自国の産業弱体化には、「原則2・3」という日本独自の直接照会システムへの警戒感があります。

米国では、知財問題は「裁判(フェアユース)」で決着をつけるのが基本で、行政が詳細な開示ルールを定めることには慎重です。

日本のこの案がそのまま通ると、司法(裁判所)というフィルターを通さずに、権利者が事業者に直接「中身を見せろ」と言える権利に近いものが生まれます。これは、訴訟コストの低い日本の法文化においては、事業者への過大な事務負担(リーガル・コスト)となり、結果として米国企業との開発競争で不利になる(独自性の副作用)という要素が強いといえるでしょう。

ミナの視点:社会と倫理のバランス、アクセル全開でのサイドブレーキ。

放送部でも、よく「自由な表現」と「誰かを傷つけないこと」のバランスについて話し合います。今回のコード案は、クリエイターを守ろうとする「優しさ」から生まれている部分もあると思いますが、それが結果として日本の技術の芽を摘んでしまうのだとしたら、本末転倒ですよね。またEU AI Act(欧州AI法)において、教育現場での特定のAI利用が「ハイリスク」に分類されたり、あるいは著作権の例外規定が議論されたり、最新のAI基本法やAI戦略といった動向まで踏まえると、これまでの日本のAIにおける社会と倫理のバランスにおいても齟齬があると考えます。

このコード案をそのまま受け入れることは、令和7年12月23日に閣議決定されたばかりの「人工知能基本計画」が掲げる「AIを基軸とした新たな経済発展」の勢いを、自ら削いでしまうことになりかねません。

「人工知能基本計画(案)」と「プリンシプル・コード(案)」の齟齬としては、「世界で最もAIを開発・活用しやすい国」という目標との乖離。基本計画では、日本を「世界で最もAIを開発・活用しやすい国」にすることを掲げています。しかし、コード案の原則2・3が求める「司法の判断を経ない直接的な情報開示」は、事業者に過大な事務・法的コストを強いるものであり、開発・活用を「しにくい」ものにする、基本理念との矛盾が生じています。次に「まず使ってみる」という社会機運の醸成を阻害します。基本計画は、利活用の加速に向け「まず使ってみる」という意識を広く社会に醸成することを求めています。対して、コード案の原則3は、利用者が自身の生成物について類似性を確認できる権利を認めていますが、これは利用者に「常に侵害のリスクや確認の手間」を意識させることになり、能動的な利活用を萎縮させるブレーキとして働く恐れがあります 。さらに「イノベーション促進とリスク対応の両立」のバランスの欠如。基本計画の3原則の一つは、イノベーション促進とリスク対応の「両立」です。コード案は「知的財産権の保護」というリスク対応に大きく傾倒しており、特に日本独自の厳しい直接照会システム(原則2・3)が、肝心のイノベーション(開発・利活用)を阻害する「一方的な制約」になっている点が齟齬と言えます 。そして「スタートアップ支援」という成長投資方針との矛盾。基本計画では、スタートアップ支援による新事業・新産業の創出を成長投資の中核としています 。一方、コード案は事業規模を問わず「生成AI事業者」を一律に対象としており、人的・財政的リソースの乏しいスタートアップが、濫用的な開示請求(原則2・3)に対応しきれず破綻しかねない、過酷な実務負担を強いる設計になっています。さらに運用上は「アジャイルな対応」と「不透明な説明責任」の齟齬があります。基本計画は、変化に即応する「アジャイル(柔軟かつ迅速)な対応」を志向しています 。しかし、コード案の「エクスプレイン(説明)」の要求は、契約上の守秘義務(NDA)がある場合でも「なぜ制限しているのか」という詳細な説明を求めるなど、迅速なビジネス判断を停滞させる、硬直的な事務負担を求めるものとなっています。

私たちがパブコメで伝えるべきは、「権利保護そのものへの反対」ではなく、「推進法という大きなアクセルを踏んだ直後に、なぜここまで強力なサイドブレーキをかけるのか」という、政策の一貫性への問いかけではないでしょうか。

意見募集の締め切りは、日本時間で令和8年(2026年)1月26日の23時59分までとなっています 。

実際の意見提出フォームはこちらです。 https://form.cao.go.jp/chitekizaisan/opinion-0019.html

詳細な資料や解説は、内閣府知的財産戦略推進事務局のページからも確認できます。 https://www.kantei.go.jp/jp/singi/titeki2/index.html

コメント